Wahltest 2025 Spart KI Zeit bei der politischen Analyse ?

Large Language Models wie ChatGPT werden bei der Verarbeitung politischer Informationen immer besser. Dennoch werden beim Zusammenfassen Aussagen immer noch unpräzise bis unzulässig verkürzt oder gesuchte Informationen hinzu hallizuniert. Eine menschliche Kontrolle bleibt daher aktuell (und wahrscheinlich noch sehr lange) unerlässlich. Wie viel Zeit erspart dann aber ein Einsatz von KI? Lohnt sich ein Einsatz überhaupt?

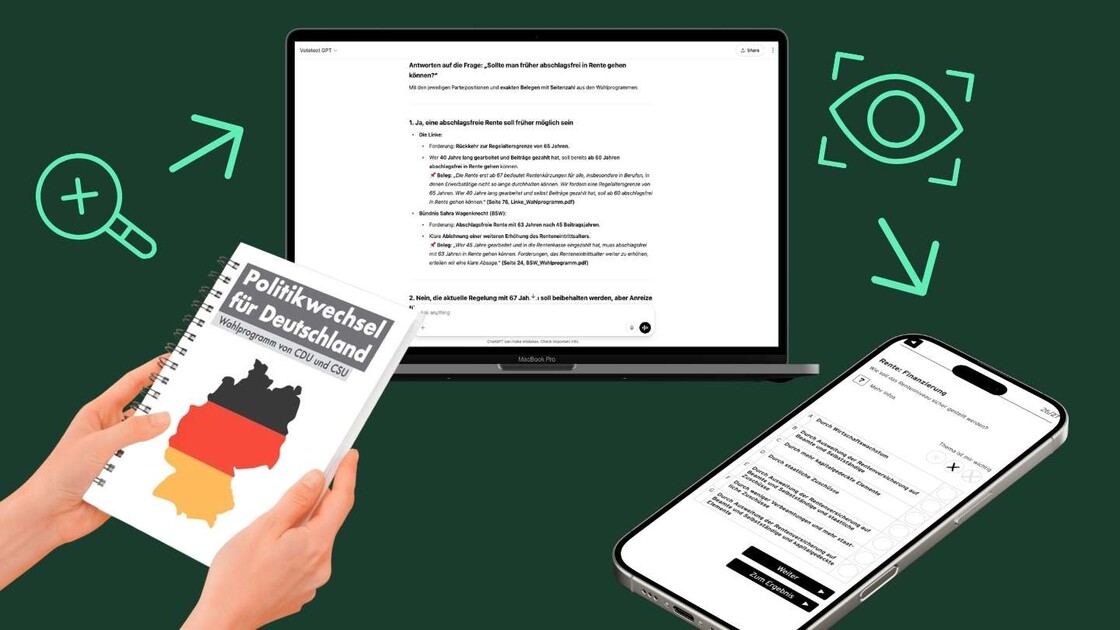

Das konnten wir Anfang 2025 anlässlich der vorgezogenen Bundestagswahl testen: Seit 2001 bieten wir mit dem Wahltest ein Tool zum spielerischen Vergleich von Wahlprogrammen an.

Programmanalyse mit dem Wahltest

Dabei durchsuchen wir die Wahlprogramme der bereits im Parlament vertretenen ca. 5-7 Parteien auf vergleichbare Vorschläge. Finden wir diese nur bei einem Teil der Parteien, recherchieren wir bei den anderen Parteien im Internet nach entsprechenden Aussagen. Das können Parteitagsbeschlüsse, parlamentarische Initiativen oder Aussagen ihres Spitzenpersonals in Interviews sein. Danach gilt es, inhaltlich ähnliche Positionen zusammenzufassen. Ziel ist, die Positionen der Parteien nicht im Wortlaut, sondern als kurze Antworten auf eine Frage wiederzugeben. Das muss nicht eine Antwort pro Frage sein, aber auch nicht zwingend nur eine Ja/Nein Antwort (wie etwa beim Wahl-O-Mat). Dabei können Unterschiede bei Details ignoriert werden, politisch wesentliche Unterschiede müssen aber erhalten und in den Antworten abgebildet werden.

Damit hatten wir eine Kombination verschiedener analytischer Aufgaben, die wir in den letzten Jahren drei Mal in vergleichbarer Form erledigt haben - ideale Voraussetzungen um für die Aufgabe dieses Mal ChatGPT statt unserer Redaktion einzusetzen und dann zu vergleichen. Dazu haben wir für zwei Monate für 40 USD ein kostenpflichtiges ChatGPT Account genutzt. Das ermöglicht einen eigenen GPT anzulegen, „Votetest GPT“ in unserem Fall und diesen mit den sieben Parteiprogrammen zu füttern.

Pre-Training

Da wir auch die vorherigen Wahltest-Analysen nicht zum ersten Mal machten, haben wir auch den Votetest GPT ein wenig vortrainiert. Das war auch aus einem anderen Grund notwendig: Aufgrund des vorgezogenen Wahltermins haben einige Parteien ihre Programme erst recht kurz vor der Wahl verabschiedet. Die wenige für die Entscheidungsfindung zur Verfügung stehende Zeit wollten wir nicht mit der Suche nach den besten Prompts verschwenden. Wir konfigurierten unseren Votetest GPT daher zunächst für die Europawahl 2024, dem letzten konventionellen Programmvergleich. So konnten wir beim Optimieren der Prompts die Ergebnisse mit den Ergebnissen unseres Redaktionsteams aus dem Vorjahr vergleichen.

Das qualitative Ergebnis

Zunächst mussten wir Chat GPT dafür sensibilisieren, Werte oder wolkige Zielumschreibungen klar von konkreten Forderungen und messbaren Zielen zu unterscheiden. Anhand von Aussagen „Wir wollen dass endlich wieder Gerechtigkeit in Deutschland herrscht“ wird man kaum Differenzen herausarbeiten können – denn wer will das nicht? Das klar zu definieren, den Votetest GPT nach konkreten Forderungen suchen zu lassen und das in einem Basis-Prompt zu hinterlegen, funktionierte im Weiteren recht gut.

Die Hinterlegung im Basis-Prompt funktionierte aber nicht immer: Obwohl hier auch die Anforderung an die Nennung von Quellen, bei Programmaussagen in Form von Seitenzahlen im PDF klar formuliert wurde, vergisst ChatGPT zumindest diese Quellen-Nennung immer wieder gerne. Gültig war die Anweisung dabei - das bestätigt ChatGPT mit einer korrekten Antwort auf die Eingabe „Wiederhole, was ich unter Quellenpflicht verstehe“. Danach verspricht die KI, es beim nächsten Mal besser machen zu wollen, nur um in 1/3 aller Fälle erneut auf die Nennung von Quellen zu verzichten.

Die Quellenangabe ist wichtig, um schnell prüfen zu können, ob die vom Votetest GPT gefundene Aussage auch im Kontext so zutrifft. Das ist eine der wesentlichsten Arbeitserleichterungen, selbst wenn in etwa einem von zehn Fällen auch die Seitenzahl halluziniert ist.

Das geht mit der aktuell noch bestehenden Tendenz von ChatGPT zum Hallizunieren einher, wenn man nur hartnäckig genug auf einer Antwort besteht. Hier müsste man prüfen, ob die Wahl einer stärker quellenorientiert arbeitenden KI wie Perplexity eine Verbesserung bietet.

Beruhigend war, dass der Fall, dass eine existierende Antwort in den Programmen nicht gefunden wurde im Pre-Training weitgehend ausgeschlossen werden konnte. Ausnahmen bildeten Passagen mit starken semantischen Abweichungen, Fälle in denen allerdings auch Menschen Probleme hätten, die Aussage zu finden.

Kern der Arbeit bildeten zwei Prompts: Recht brauchbar waren die Ergebnisse des Prompts „Durchsuche die Programme der Parteien auf übereinstimmende Forderungen zum Thema ####“. Dabei hangelt man sich vom Oberthema zu Unterthemen. Je klarer sich anhand der Parteipositionen Unterschiede herausarbeiten lassen, desto besser. Die Entscheidung, auf welche Aspekte man sich dabei am besten konzentriert, wurde der KI gar nicht erst überlassen.

Stand das Unterthema fest, konnte man den Votetest GPT um Vorschläge für eine Aufbereitung der Positionen in das gewünschte Frage-Antwortschema bitten. Die Ergebnisse taugten hierbei in der Regel bestenfalls als Inspiration.

Hat man sich für eine Fragestellung entschieden hat der Prompt „Bitte formuliere Antworten auf die Fragestellung ‚######?‘ und weise die Parteipositionen unter Nennung der relevanten Forderungen den Antworten zu“ dagegen als große Arbeitserleichterung erwiesen – sofern die Quellen genannt wurden. Allerdings wurden Parteien, die sich im Frage-Antwort-Schema nicht mehr wiederfanden kurzerhand weggelassen. In etwa der Hälfte der Fälle konnte die KI dennoch Antworten durch eine Recherche im Internet ergänzen. Diese selbst mit Hilfe von Suchmaschinen zu recherchieren hätte ein Vielfaches länger gebraucht, da die KI die Relevanz der Quelle im Sinne der Fragestellung effizienter berücksichtigen kann als eine einfache Suchmaschine.

Das quantitative Ergebnis

Damit zurück zur Eingangsfrage. Spart das unterm Strich Zeit?

Hierbei sind zwei Werte zu unterscheiden. Den Netto-Zeitaufwand mit trainiertem Modell und den Brutto-Zeitaufwand inklusive der Vorbereitung anhand der Europawahl-Daten. Letzteres ist relevant wenn man für unwahrscheinlich hält, dass die aktuelle Konfiguration beim nächsten Mal einfach wieder genauso eingesetzt werden würde.

Beim menschlichen Einsatz gibt es auch einen Brutto- und einen Netto-Wert. Der Brutto-Wert beinhaltet einen geschätzten Aufwand in der Personalplanung, die sich in den reinen Stundenbuchungen der Redakteure nicht abbildet:

Die Ergebnisse im Überblick:

| Brutto | Netto | |||

| Bundestagswahl 2021 | 65:45 h | 62:30 h | ||

| Présidentielles 2022 (Zusatzaufwand: Werksstudent*innen des SciencesPo) | 91:30 h | 79:00 h | ||

| Wahl des Europäischen Parlaments 2024 (Zusatzaufwand: Teamwechsel) | 191:15 h | 156:45 h | ||

| Durchschnitt | 116:10 h | 99:25 h | ||

| Bundestagswahl 2025 (Zusatzaufwand: GPT Training) | 46:45 h | 31:15 h | ||

| Zeitersparnis | 60% | 68% |

Fazit:

Im vorliegenden Fall konnten durch den Einsatz eines vortrainierten GPT die Aufwände sowohl in der Netto- wie in der Bruttobetrachtung deutlich reduziert werden.

Die Unterschiede sind so hoch, dass selbst wenn unsterstellt würde, dass Prompting und Supervision von KI-Ergebnissen eine höhere Qualifikation erfordert als die bisherige redaktionelle Aufarbeitung, bliebe sowohl in der Netto wie in der Brutto-Betrachtung der KI Einsatz ökonomischer. Vor allem aber ermöglicht der KI Einsatz eine schnellere Aufarbeitung - und in der politischen Debatte somit auch eine höhere Reaktionsgeschwindigkeit.

Ein Nachteil bleibt allerdings. Bei der redaktionellen Erschliessung bleibt nicht aus, die Programme zumindest kursorisch einmal von Vorne nach Hinten durchzulesen. Damit bekommt man ein anderes Gefühl und Verständnis von der Programmatik, von der Schlüssgkeit der Argumentation und von Leitbildern, die sich durch die Programmatik hindurchziehen. Anders als in der atomisierten Betrachtung von Versatzstücken durch die Brille der KI. Zumindest für die Bearbeiter*innen geht dadurch ein Stück Erkenntnis verloren.